爬虫下载文件的能力

- 爬虫的基本功能

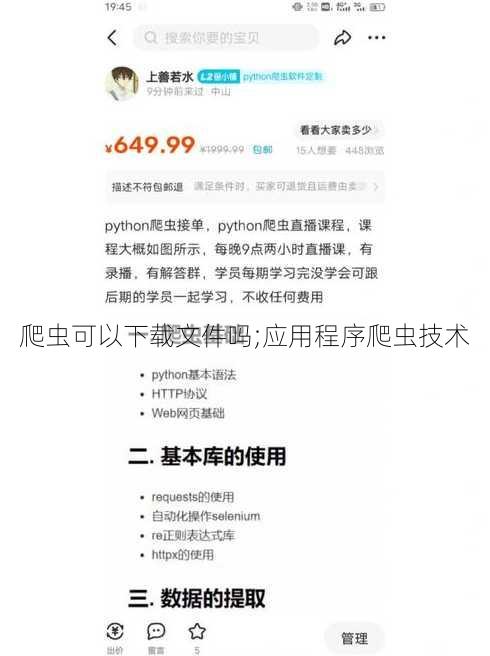

爬虫,即网络爬虫,是一种自动化程序,用于从互联网上抓取信息。它能够按照一定的规则,自动地获取网页内容,并将这些内容存储起来。除了获取网页内容,爬虫还可以具备下载文件的能力。

- 爬虫下载文件的方式

爬虫下载文件主要有以下几种方式:

直接下载:如果网页上提供了文件的下载链接,爬虫可以直接点击链接,按照HTTP协议下载文件。

解析下载:如果网页中包含文件的链接,但不是直接提供的下载链接,爬虫需要解析网页内容,找到实际的下载链接,然后进行下载。

模拟下载:对于一些需要登录或验证的文件下载,爬虫需要模拟用户的行为,完成登录和验证过程,才能下载文件。

- 应用场景

爬虫下载文件的应用场景非常广泛,例如:

数据采集:从网站下载大量数据,用于后续分析和处理。

内容聚合:从多个网站下载内容,聚合到一个平台,方便用户阅读。

资源下载:下载图片、视频、音乐等资源,用于个人或商业用途。

应用程序爬虫技术

- 应用程序爬虫的定义

应用程序爬虫,是指针对特定应用程序(如网站、移动应用等)进行数据抓取的爬虫。与通用爬虫相比,应用程序爬虫更加专注于特定领域的应用。

- 应用程序爬虫的特点

针对性:针对特定应用程序进行数据抓取,更加高效。

定制化:可以根据需求定制爬虫的规则和功能。

稳定性:针对特定应用程序进行优化,提高爬虫的稳定性。

- 应用程序爬虫的应用场景

网站内容监控:实时监控网站内容的更新,及时发现异常情况。

竞品分析:分析竞争对手的产品和策略,为自身发展提供参考。

舆情监控:监测网络上的舆论动态,及时了解公众观点。

FAQs

Q1:爬虫下载文件是否合法?

合法下载:如果网站提供了公开的下载链接,且下载内容不侵犯他人版权,那么下载文件是合法的。

非法下载:如果下载内容侵犯了他人版权,或者下载行为违反了网站的使用协议,那么下载文件是非法的。

Q2:爬虫下载文件会对网站造成影响吗?

少量爬虫:少量爬虫对网站的影响通常较小。

大量爬虫:大量爬虫可能会对网站服务器造成压力,甚至导致网站崩溃。

Q3:如何防止爬虫下载文件?

设置robots.txt:网站可以通过设置robots.txt文件,限制爬虫的访问范围。

使用验证码:网站可以通过验证码来防止爬虫自动下载文件。

限制IP访问:网站可以通过限制IP访问来防止爬虫。